ToF และ LiDAR เป็นฟีเจอร์บนกล้องของสมาร์ทโฟนที่น้อยคนนักจะรู้ว่ามันมีเอาไว้ทำอะไรและแตกต่างกันอย่างไร วันนี้ทาง SpecPhone จึงขอนำเอาฟีเจอร์ทั้ง 2 มาเผยแบบหมดจดให้ทุกท่านได้ทราบกัน

LiDAR เป็นหนึ่งในฟีเจอร์เอกสิทธิ์เฉพาะของ Apple ที่ช่วยทำให้ iOS แตกต่างจาก Android (แต่อย่างน้อยก็ต่อเมื่อคุณรู้ว่า LiDAR คืออะไร) เทคโนโลยีนี้มีความสำคัญอย่างยิ่งสำหรับการเปิดใช้งานความเป็นจริงเสริมบนมือถือ(หรือ AR) อย่างไรก็ตามเช่นเดียวกับคุณสมบัติเทคโนโลยีพิเศษเฉพาะของ Apple ส่วนใหญ่ สำหรับทางส่วนของ Android นั้นก็จะมีฟีเจอร์หรือเทคโนโลยีที่คล้ายๆ กันอย่างเช่น ToF ซึ่งมีอยู่ในโทรศัพท์รุ่นเรือธงของ Samsung

ไม่ว่าคุณจะเป็นนักพัฒนาแอปพลิเคชัน, เป็นผู้ที่ชื่นชอบอุปกรณ์ใหม่หรือแค่อยากรู้ว่าเจ้า LIDAR และ ToF นั้นต่างกันอย่าง เราอยากให้คุณสละเวลาสักนิดเพื่ออ่านบทความนี้แล้วเปิดใจที่จะเรียนรู้ข้อมูลเชิงลึกของ LIDAR และ ToF เราขอรับรองเลยว่าคุณจะไม่เสียเวลาไปเปล่าๆ อย่างแน่นอน ถ้าพร้อมแล้วนั้นก็เริ่มกันได้เลย

- ToF คืออะไร

- LiDAR คืออะไร

- LiDAR และ ToF ต่างกันอย่างไร

- ToF และ LiDAR ทำงานร่วมกับ Mobile AR อย่างไร

- LiDAR ดีกว่า ToF หรือไม่

- เหตุใด Apple และ Google จึงใช้เซ็นเซอร์ความลึกต่างกัน

ToF คืออะไร

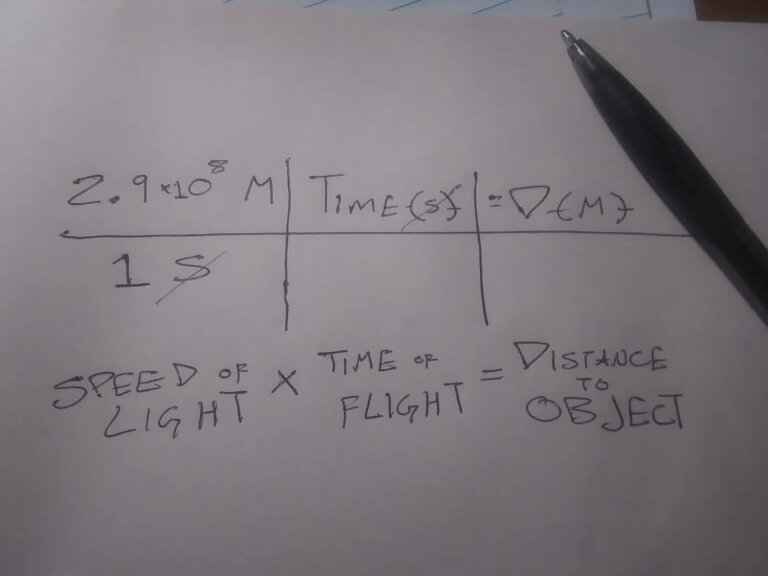

ToF ย่อมาจากคำว่า Time of Flight ในทางเทคนิคแล้ว ToF หมายถึงการใช้ความเร็วแสง(หรือแม้แต่เสียง) เพื่อกำหนด(หรือวัด) ระยะทางจากกล้องไปยังวัตถุที่คุณต้องการถ่าย

เซ็นเซอร์ ToF พิเศษจะวัดเวลาที่แสง(หรือเสียง) ออกจากอุปกรณ์ไปทำการกระกับวัตถุหรือระนาบที่คุณต้องใช้ในการถ่าย แล้วส่งย้อนกลับมายังอุปกรณ์ หากเราเอาค่าที่ ToF วัดได้มาหารด้วยเลขสองคุณก็จะได้ระยะทางจากอุปกรณ์ของคุณ(ในที่นี้ก็คือสมาร์ทโฟนที่มาพร้อมกับเซ็นเซอร์ ToF) ไปยังวัตถุหรือระนาบที่คุณต้องการถ่าย

ดังนั้นหากจะว่าไปแล้วจริงๆ เทคโนโลยี LiDAR ก็ถือว่าเป็นประเภทหนึ่งของ Time of Fight(ToF) แต่ไม่ใช่ทุก Time of Flight(ToF) นั้นจะเป็น LiDAR เพื่อให้ทุกอย่างง่ายขึ้นในการเข้าใจความหมายของ ToF นั้นเราจะหมายความว่า “ToF” นั้นใช้เทคโนโลยีการวัดระยะทางด้วยแสงนั่นเอง

LiDAR คืออะไร

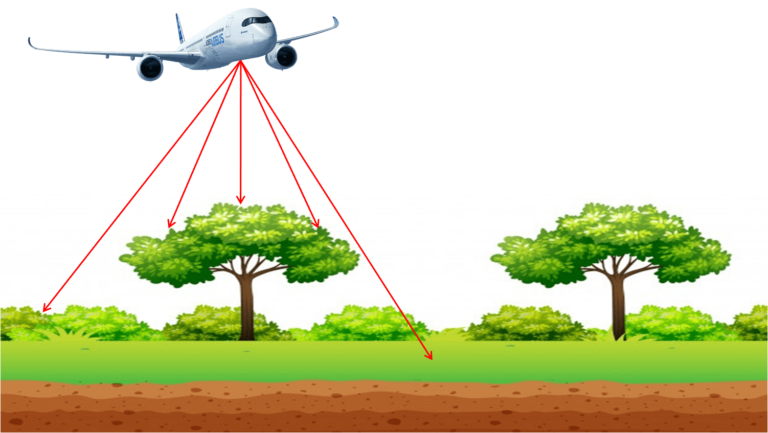

LiDAR ย่อมาจาก Light Detection and Ranging ซึ่งเจ้า LiDAR นี้จะใช้เลเซอร์หรือกริดของเลเซอร์เป็นแหล่งกำเนิดแสงสำหรับการวัดระยะของวัตถุ

การอ่านค่า LiDAR เพียงครั้งเดียวสามารถใช้วัดสิ่งต่างๆ ได้เช่นความกว้างของห้องเป็นต้น อย่างไรก็ตามการอ่านค่า LiDAR หลายครั้งสามารถใช้เพื่อสร้าง “point clouds” สิ่งเทคโนโลยีดังกล่าวนี้สามารถใช้เพื่อสร้างแบบจำลองสามมิติของวัตถุหรือแผนที่ภูมิประเทศได้

แม้ว่า LiDAR อาจยังใหม่สำหรับอุปกรณ์เคลื่อนที่(ในที่นี้ก็คือสมาร์ทโฟน) แต่จริงๆ แล้วเทคโนโลยี LiDAR มีมาตั้งแต่ปี 1960 เพียงแต่ว่าไม่ได้ถูกนำเอาใช้บนสมาร์ทโฟนจนกระทั่งทาง Apple เอาเทคโนโลยีมาสู่ iPhone เทคโนโลยี LiDAR นั้นสามารถใช้ทำอะไรได้หลายๆ อย่างตั้งแต่การทำแผนที่สภาพแวดล้อมใต้น้ำไปจนถึงการค้นพบแหล่งโบราณคดีจากการยิงแสงจากดาวเทียม

LiDAR และ ToF ต่างกันอย่างไร

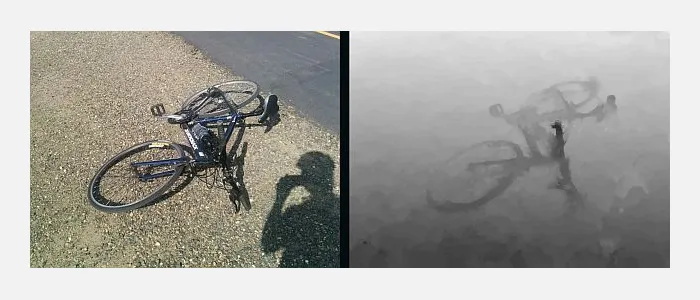

ความแตกต่างในการทำงานระหว่าง LiDAR และ ToF นั้นก็คือ LiDAR ใช้เลเซอร์พัลซิ่งเพื่อสร้าง point cloud ซึ่งจากนั้นข้อมูลระยะที่ถูกอ่านค่าได้จะถูกนำมาใช้ในการสร้างแผนที่หรือรูปภาพ 3 มิติ ส่วนเทคโนโลยีอย่าง ToF นั้นจะสร้าง “แผนที่เชิงลึก” ตามการตรวจจับแสงซึางโดยปกติจะผ่านกล้อง RGB มาตรฐานทั่วำได้

ข้อได้เปรียบของ ToF ที่เหนือกว่า LiDAR คือ ToF ต้องการอุปกรณ์พิเศษน้อยกว่าเพื่อให้สามารถใช้กับอุปกรณ์ขนาดเล็กและราคาไม่แพง ทว่าประโยชน์ของ LiDAR นั้นจะมาจากความง่ายที่คอมพิวเตอร์สามารถอ่าน point cloud ได้เมื่อเทียบกับการวัดค่าแผนที่เชิงลึก

Depth API ที่ Google สร้างขึ้นสำหรับอุปกรณ์ Android ทำงานได้ดีที่สุดบนอุปกรณ์ที่เปิดใช้งาน ToF และมันจะทำงานโดยการสร้างแผนที่เชิงลึกและจดจำ “feature points” ซึ่งเจ้า feature points เหล่านี้มักจะกั้นระหว่างความเข้มของแสงต่างๆ ที่แตกต่างกันไป ToF จะถูกใช้เพื่อระบุระนาบต่างๆ ในสภาพแวดล้อมแล้วนำมาสร้าง feature points ที่มีความละเอียดต่ำเป็นหลัก

ToF และ LiDAR ทำงานร่วมกับ Mobile AR อย่างไร

เทคโนโลยีการสำหรับการวัดแผนที่เชิงลึกและ feature points นั้นถือว่าเป็นอะไรที่ยอดเยี่ยมเอามากๆ และสำหรับบางคนและบางแอพพลิเคชันนั้น LiDAR ก็เพียงพอแล้วสำหรับการใช้งานตัวอย่างเช่น การสร้างแผนที่เชิงลึกช่วยให้กล้องสมาร์ทโฟนสามารถที่จะจับโฟกัสได้อย่างถูกต้อง นอกไปจากนั้น LiDAR เป็นเทคโนโลยีที่ช่วยให้ iPhone สามารถที่จะสแกนใบหน้าของคุณเพื่อทำการปลดล็อกหน้าได้(ซึ่งสมาร์ทโฟนระบบปฏิบัติการ Android รุ่นใหม่ๆ ก็สามารถทำได้เช่นเดียวกัน)

อย่างไรก็ตาม สำหรับแอปพลิเคชัน AR (Augmented Reality) ที่เป็นเทคโนโลยีสำหรับการทำวัตถุ 3 มิติ มาจำลองเข้าสู่โลกจริงให้มีความสมบูรณ์มากยิ่งขึ้น อย่างไรก็ตามทั้ง ToF และ LiDAR สามารถที่จะทำ AR ได้โดยจะทำงานร่วมกับเซ็นเซอร์อุปกรณ์เคลื่อนที่อื่นๆ (ในที่นี้ก็คือสมาร์ทโฟน) และโดยเฉพาะอย่างยิ่งกับแพลตฟอร์มที่จำเป็นต้องเข้าใจการวางแนวและการเคลื่อนไหวของสมาร์ทโฟนของคุณ

การทำความเข้าใจตำแหน่งของอุปกรณ์ภายในสภาพแวดล้อมที่แมปเรียกว่า Simultaneous Localization and Mapping (SLaM) ซึ่งเจ้า SLaM นี้มีความจำเป็นสำหรับใช้งานควบคู่กับแอปพลิเคชัน AR บนมือถือเพื่อวางวัตถุดิจิทัลในสภาพแวดล้อมจริง

ปัจจัยสำคัญอีกประการหนึ่งในการวางวัตถุดิจิทัลในแอปพลิเคชันที่ใช้ LiDAR และ ToF นั้นเกี่ยวข้องกับ “anchors หรือจุดยึด” ซึ่งจุดยึดนั้นก็คือจุดดิจิทัลในโลกจริงที่เราจะนำเอาวัตถุเสมือนไปทำการ “ติด” กับวัตถุดิจิทัล

ตัวอย่างที่เห็นได้ชัดเจนมากที่สุดของการใช้งาน ToF และ LiDAR ก็คือแอปพลิเคชันเกมที่เคยถูกกล่าวถึงอย่างกว้างขวางในระดับโลกกับเกม Pokemon Go การดำเนินการนี้จะผ่านกระบวนการแยกต่างหากที่เรียกว่า “Geotagging หรือการแท็กตำแหน่ง” อย่างไรก็ตามในแอปพลิเคชัน AR บนมือถือนั้นวัตถุดิจิทัลจะยึดกับจุดใน point cloud ที่ถูกสร้างขึ้นจากฟีเจอร์ ToF และ LiDAR

LiDAR ดีกว่า ToF หรือไม่

ตามทฤษฎีนั้นเทคโนโลยี LiDAR จะสามารถทำการวัดระยะของอุปกรณ์กับวัตถุที่ต้องการได้เร็วกว่าและแม่นยำกว่า Time of Flight(ToF) อย่างไรก็ตาม นอกจากนั้นมันยังมีความสำคัญมากขึ้นเมื่อแอปพลิเคชันขั้นถูกออกแบบมาให้ใช้เทคโนโลยี LiDAR ได้

อย่างไรก็ตามเทคโนโลยีอย่าง ToF และ Depth API ของ Google นั้นจะมีปัญหาในการทำความเข้าใจระนาบพื้นผิวขนาดใหญ่และพื้นผิวต่ำเช่นผนังสีขาวซึ่งอาจทำให้แอปพลิเคชันที่ใช้วิธีนี้วางวัตถุดิจิทัลบนพื้นผิวบางอย่างในโลกความเป็นจริงได้ไม่แม่นยำเท่าไรนัก แต่กับแอปพลิเคชันที่ใช้ LiDAR นั้นจะมีโอกาสน้อยที่จะเกิดปัญหานี้ดังกล่าวนี้

แอปพลิเคชันที่เกี่ยวข้องกับสภาพแวดล้อมที่ใหญ่ขึ้นหรือมีพื้นผิวที่หลากหลายมากขึ้นไม่น่าจะมีปัญหานี้ นอกจากนี้ แอปพลิเคชัน AR สำหรับผู้บริโภคที่ใช้สมาร์ทโฟนส่วนใหญ่เกี่ยวข้องกับการใช้ตัวกรอง AR บนใบหน้าหรือร่างกายของผู้ใช้เอง ทำให้เทคโนโลยีอย่าง ToF นั้นก็เพียงพอมากแล้วที่จะไม่ก่อให้เกิดปัญหาที่เราได้กล่าวไปในตอนต้นหากใช้งานกับพื้นผิวที่ไม่มีพื้นผิวขนาดใหญ่มากจนเกินไปนัก

เหตุใด Apple และ Google จึงใช้เซ็นเซอร์ความลึกต่างกัน

ในการเปิดตัวสมาร์ทโฟนที่มาพร้อมกับ LiDAR นั้นทาง Apple ได้กล่าวเอาไว้ว่าพวกเขารวมเซ็นเซอร์รวมถึงฮาร์ดแวร์อื่นๆ เพื่อทำการ “เปิดการทำงานที่ลื่นไหลให้กับผู้ใช้งานในระดับมืออาชีพได้มากขึ้นซึ่งมันจะรองรับแอปพลิเคชันภาพถ่ายและวิดีโอระดับมืออาชีพ” ตัวอย่างที่ชัดเจนมากที่สุดที่ใช้เทคโนโลยี LiDAR ได้อย่างแยบยลก็คือ iPad Pro ที่รองรับ LiDAR ซึ่งทาง Apple ได้กล่าวเอาไว้ว่า iPad Pro นั้นเป็นอุปกรณ์ที่ดีที่สุดในโลกสำหรับการสร้าง AR หรือความเป็นจริงเสริม

Google ไม่ได้ให้คำอธิบายที่ชัดเจนว่าทำไม Depth API และอุปกรณ์ของทาง Google จึงไม่ใช้ LiDAR เหมือนกับของทาง Apple ซึ่งในความเป็นจริงแล้วหากทาง Google เปลี่ยนมาใช้เทคโนโลยี LiDAR มันก็จะช่วยทำให้อุปกรณ์ Android นั้นมีน้ำหนักเบาและราคาถูกมากขึ้น

อีกสาเหตุหนึ่งที่ทาง Google ไม่รวมเอาเทคโนโลยี LiDAR ไว้บนระบบปฏิบัติการ Android นั้นก็เนื่องมาจาก Android ทำงานบนอุปกรณ์พกพาที่ผลิตโดยหลายบริษัท ทำให้การใช้ LiDAR นั้นจะไม่มีประโยชน์อะไรมากนักหากทางผู้ผลิตไม่นำเอาเทคโนโลยีอย่าง LiDAR ไปใช้ร่วมกับอุปกรณ์เคลื่อนที่ของตัวเอง แถมเทคโนโลยี LiDAR นั้นก็ทำให้ตัวเครื่องอุปกรณ์จะมีราคาสูงมากขึ้นไปอีก นอกจากนี้ Depth API ยังสามารถใช้งานร่วมกับอุปกรณ์อื่นๆ ได้อีกมากมายเนื่องจากสามารถใช้งานร่วมกับเซนเซอร์มาตรฐานได้อยู่แล้ว

อันที่จริง Depth API ของ Google นั้นไม่เทคโนโลยีระกับเทพสำหรับอุปกรณ์ระบบปฏิบัติการ Android ซึ่งหมายความว่านักพัฒนาที่ใช้แพลตฟอร์มสร้างประสบการณ์ AR ของ Google ยังสามารถพัฒนาประสบการณ์ที่ทำงานบนอุปกรณ์ Apple ได้อีกด้วยต่างหากโดยไม่จำเป็นที่จะต้องเขียนโค๊ดใหม่เพื่อให้เข้ากันได้กับเทคโนโลยี LiDAR

ในบทความนี้เรามุ่งเน้นไปที่ LiDAR และ ToF กับประสบการณ์ AR บนสมาร์ทโฟนเป็นหลักเพราะประสบการณ์ที่ซับซ้อนเหล่านี้ต้องการคำอธิบายมากที่สุดแถมการใช้งาน AR จริงๆ แล้วนั้นก็สร้างความสนุกให้กับผู้ใช้สมาร์ทโฟนระบบปฏิบัติการ Android ได้ดีอยู่แล้ว

ที่มา : ios.gadgethacks, makeuseof